竞赛中10种数据预处理中的数据泄露模式解析

超参数搜索确实是机器学习生命周期中不可或缺的一步,特别是在模型性能方面。正确的超参数选择可以显著提高模型的准确性、对未见数据的泛化能力以及收敛速度。不当的超参数选择可能导致过拟合或欠拟合等问题。

一些常见的超参数例子包括梯度基算法中的学习率,或者决策树算法中树的深度,这些可以直接影响模型准确拟合训练数据的能力。超参数调优涉及在复杂的、高维的超参数空间中搜索模型的最佳配置。挑战不仅在于计算成本,还在于模型复杂性、泛化能力和过拟合之间的权衡。

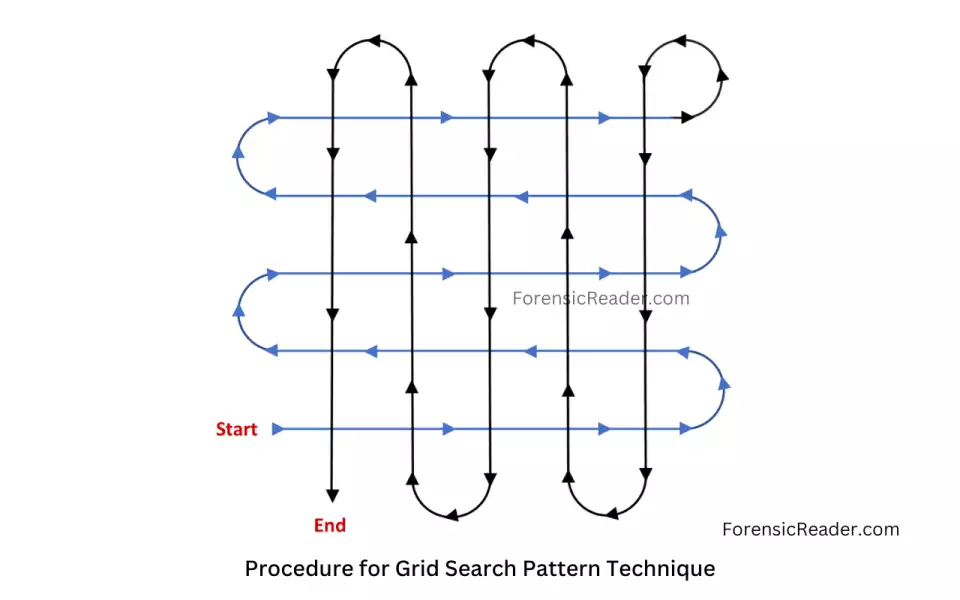

方法1:网格搜索

网格搜索(Grid Search)是一种流行的超参数优化方法,它系统地遍历多种超参数的组合。这种方法简单、直观,但可能在高维参数空间中变得非常耗时和计算密集。

网格搜索会生成所有可能的参数组合。如果你有两个超参数,每个参数有3个可能的值,那么网格搜索将会产生 9 种不同的参数组合。

- 简单易懂:网格搜索的概念直观,易于理解和实现。

- 全面搜索:如果你定义的参数网格足够密集,网格搜索可以保证找到全局最优解。

- 计算成本高:随着超参数数量和每个参数的可能值数量增加,需要评估的组合数量呈指数级增长,这可能导致计算成本非常高。

fromsklearnimportsvm,datasetsfromsklearn.model_selectionimportGridSearchCViris=datasets.load_iris()parameters={'kernel':('linear','rbf'),'C':[1,10]}svc=svm.SVC()clf=GridSearchCV(svc,parameters)clf.fit(iris.data,iris.target)sorted(clf.cv_results_.keys())方法2:随机搜索

随机搜索(Random Search)是另一种流行的超参数优化方法,与网格搜索相比,它不尝试遍历所有可能的参数组合,而是在参数空间中随机选择参数组合进行评估。

随机搜索会从这些分布中随机抽取参数值,形成参数组合。每次抽取都是独立的,这意味着同一参数的不同组合可以被多次抽取。

- 灵活性:随机搜索可以很容易地处理连续参数和离散参数。

- 避免局部最优:由于随机搜索的随机性,它不太可能陷入局部最优解,有更高的机会探索到全局最优解。

- 结果不可重复:每次运行随机搜索可能会得到不同的结果,因为参数组合是随机选择的。

fromsklearn.datasetsimportload_irisfromsklearn.linear_modelimportLogisticRegressionfromsklearn.model_selectionimportRandomizedSearchCVfromscipy.statsimportuniformiris=load_iris()logistic=LogisticRegression(solver='saga',tol=1e-2,max_iter=200,random_state=0)distributions=dict(C=uniform(loc=0,scale=4),penalty=['l2','l1'])clf=RandomizedSearchCV(logistic,distributions,random_state=0)search=clf.fit(iris.data,iris.target)search.best_params_方法3:贝叶斯优化

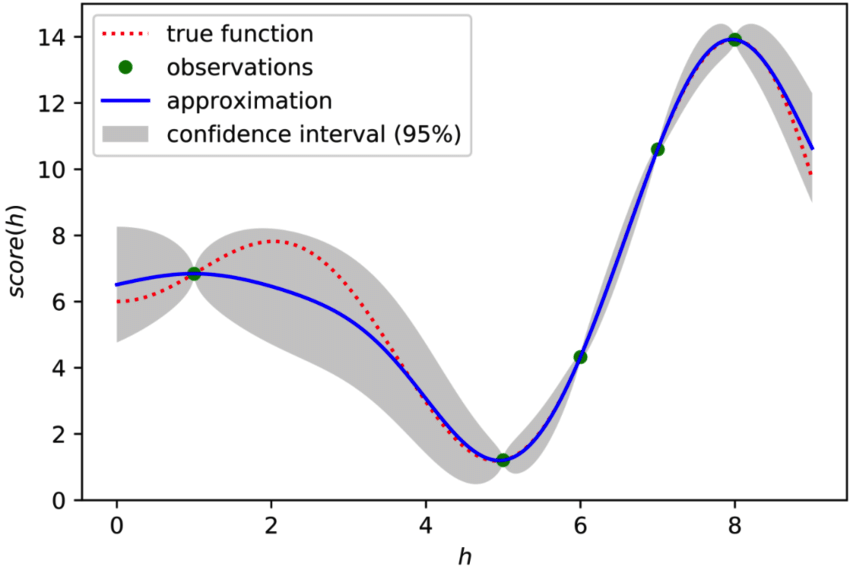

贝叶斯优化核心思想是构建一个概率模型,该模型能够预测目标函数(通常是模型的性能指标,如准确率或损失)在不同超参数组合下的表现。

这个概率模型通常是基于高斯过程(Gaussian Process),它能够根据已有的观测数据(即之前评估过的超参数组合及其对应的性能指标)来预测新的超参数组合的性能,并据此选择新的超参数组合进行评估。

- 避免稀疏梯度和探索-利用平衡问题:贝叶斯优化避免了传统优化方法中遇到的稀疏梯度和探索-利用平衡问题的影响。

- 提高搜索效率:贝叶斯优化能够有效地搜索高维参数空间,从而提高搜索效率

defblack_box_function(x,y):"""Functionwithunknowninternalswewishtomaximize.Thisisjustservingasanexample,forallintentsandpurposesthinkoftheinternalsofthisfunction,i.e.:theprocesswhichgeneratesitsoutputvalues,asunknown."""return-x**2-(y-1)**2+1frombayes_optimportBayesianOptimizationpbounds={'x':(2,4),'y':(-3,3)}optimizer=BayesianOptimization(f=black_box_function,pbounds=pbounds,random_state=1,)optimizer.maximize(init_points=2,n_iter=3,)方法4:模拟退火

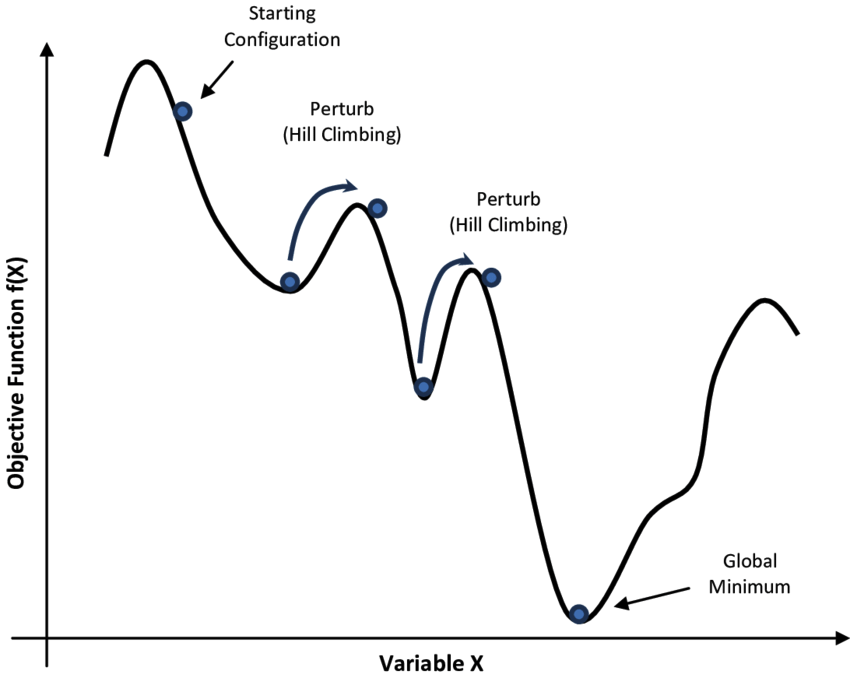

模拟退火算法(Simulated Annealing,简称SA)是一种基于概率的启发式随机搜索优化算法,灵感来源于物理中的退火过程。它通过模拟金属退火过程中分子运动的方式来解决复杂的优化问题。

从一个初始解开始,并设置一个较高的初始温度。在当前解的邻域中随机生成一个新的解,计算新解的目标函数值。如果新解比当前解好,则接受新解;如果新解比当前解差,仍然以一定的概率接受新解。

- 全局优化:模拟退火算法能够在整个解空间中进行搜索,有助于找到全局最优解,尤其适用于解决具有多个局部最优解的复杂问题。

- 随机性:算法通过随机扰动和接受劣解的方式,增加了搜索过程的随机性,有助于跳出局部最优解。

方法5:遗传算法

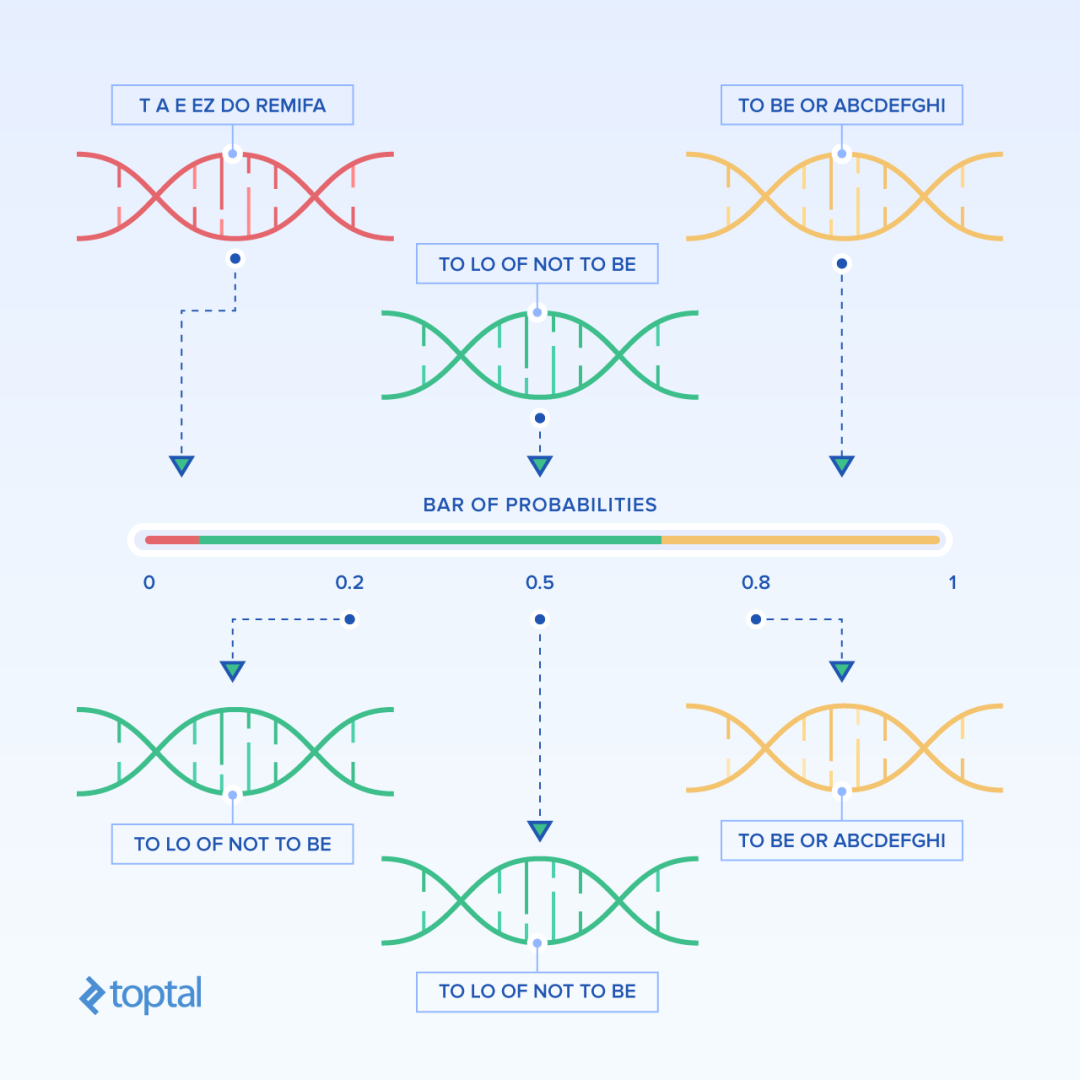

遗传算法(Genetic Algorithm, GA)是一种模拟自然界进化过程的优化算法,它基于自然选择和群体遗传机理,通过模拟繁殖、杂交和突变等现象来求解优化问题。

随机生成一个初始种群,每个个体(解决方案)被编码为一个染色体,将两个个体的一部分基因组合在一起,生成新的个体。随机更改个体的一些基因值,以引入新的遗传变异。

- 全局搜索能力:遗传算法采用群体方式进行搜索,能够有效地探索整个搜索空间,避免陷入局部最优解。

- 并行性:遗传算法天然适合并行计算,因为每个个体的评估和选择过程相对独立

方法6:连续减半

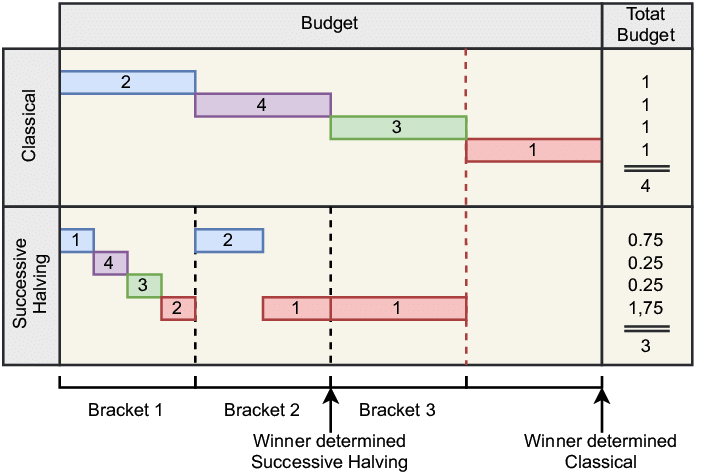

Successive Halving(连续减半)算法是一种高效的超参数优化方法,特别适用于大规模的参数搜索问题。

Successive Halving是一种迭代选择过程,它通过逐步减少候选解的数量并增加剩余候选解的资源分配来优化超参数。这种方法类似于“锦标赛”或“达尔文进化”,其中表现不佳的候选解会被淘汰,而表现较好的候选解则获得更多的资源以进行进一步的评估。

fromsklearn.datasetsimportload_irisfromsklearn.ensembleimportRandomForestClassifierfromsklearn.experimentalimportenable_halving_search_cv#noqafromsklearn.model_selectionimportHalvingGridSearchCVX,y=load_iris(return_X_y=True)clf=RandomForestClassifier(random_state=0)param_grid={"max_depth":[3,None],"min_samples_split":[5,10]}search=HalvingGridSearchCV(clf,param_grid,resource='n_estimators',max_resources=10,random_state=0).fit(X,y)search.best_params_方法7:大模型思维链

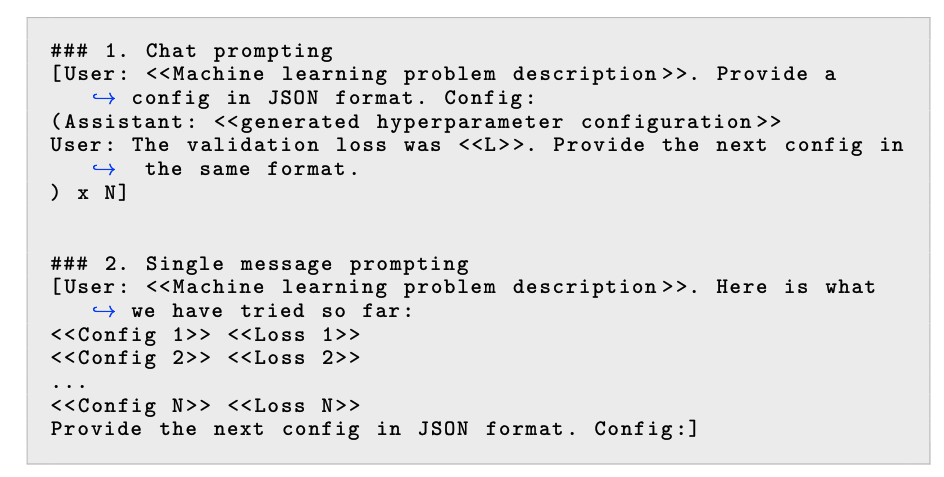

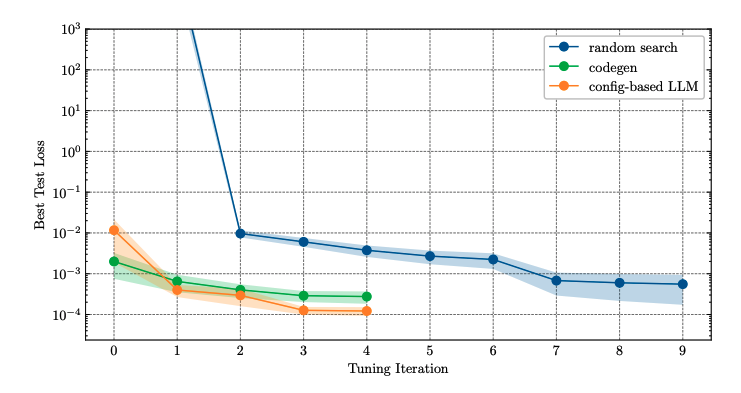

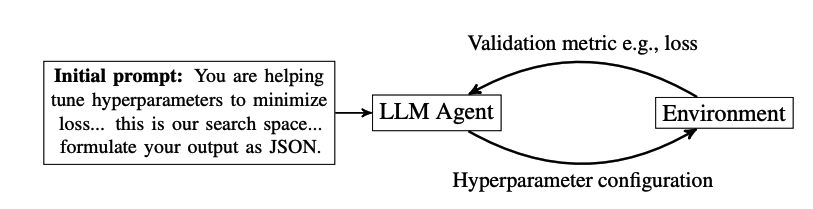

在超参数优化中,LLMs可以被用来推荐一组超参数进行评估。在接收到这些超参数后,根据提议的配置训练模型,并记录最终的指标(例如,验证损失)。然后,再次询问LLM以获取下一组超参数。这个过程是迭代的,直到耗尽搜索预算。

LLMs在进行超参数优化时,可以利用链式思考推理,这意味着它们可以生成解释其推荐的理由。这种推理能力可以帮助理解模型为何推荐特定的超参数,并提供更深入的洞察。