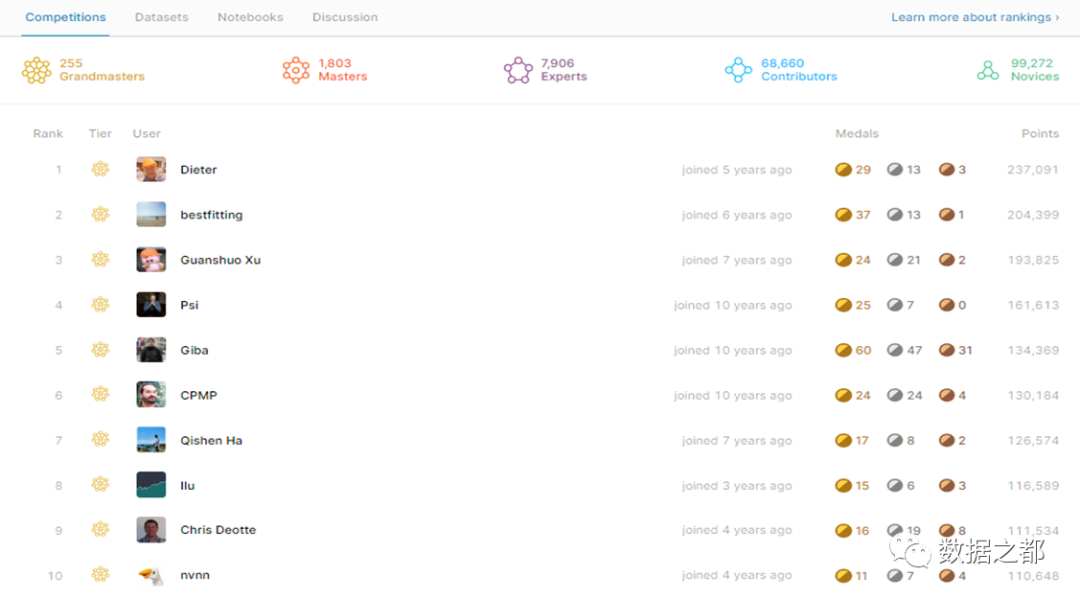

Kaggle是全世界数据科学爱好者的竞技场,每个月都会有若干项目开放出来,如果能通过竞技拿到金牌或者银牌,不仅证明了自己数据挖掘能力已经到了一个不错的地步,也能带来一定的成就感。更重要的是,kaggle竞赛如果取得靠前的名次,对于实习、求职、留学申请都是很好的加分项。

那么,新手如何快速进阶kaggle比赛呢?

除了常规的python编程、基本的机器学习知识以外,还有很多技巧和规律,下面小编就来一一揭开。

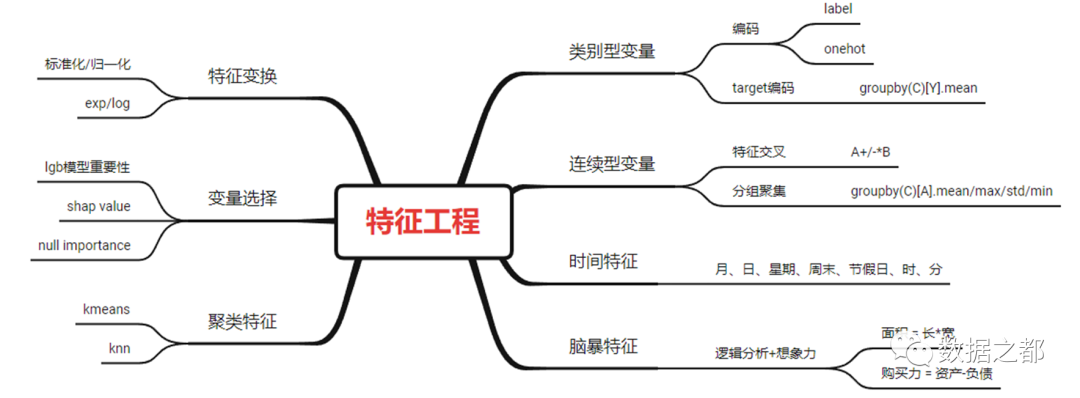

1 特征工程

在kaggle竞赛中,特征工程通常占据了数据科学家很大一部分的精力,一方面是因为特征工程能够显著提升模型性能,高质量的特征能够大大简化模型复杂度,让模型变得高效且易理解、易维护。另一方面对于一个机器学习问题,数据和特征决定了机器学习的上限,而模型和算法只是逼近这个上限而已。

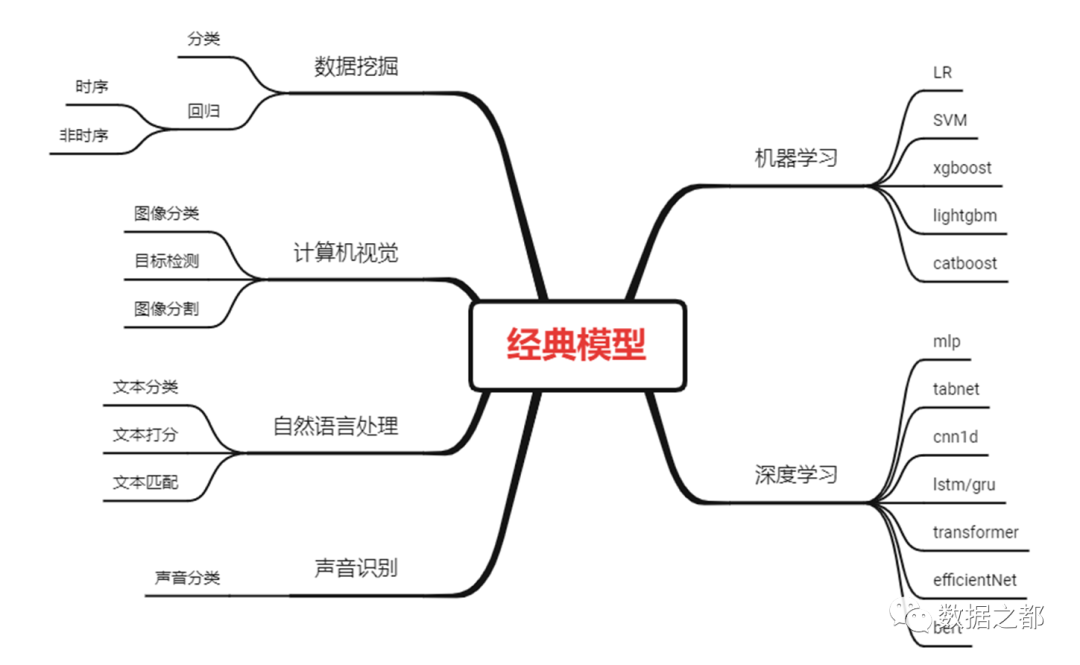

2 实用模型

Kaggle比赛中最常用的模型包括XGBoost、LightGBM、CatBoost、Tabnet、MLP和Transformer。熟练掌握这些模型,就已经具有了达到Kaggle Expert的能力,并且能够快速解决很多实际场景的问题,受益匪浅。

对于数据挖掘问题,XGBoost、LightGBM、CatBoost三个模型是必备,查看kaggle过往比赛中,获奖模型基本有这三个模型包揽,深度学模型虽然有很多优势,但在数据挖掘问题上,树模型的优势显然是不可替代的。

XGBoost

XGBoost是eXtreme Gradient Boosting的缩写称呼,它是一个非常强大的Boosting算法工具包,优秀的性能(效果与速度)让其在很长一段时间内霸屏数据科学比赛解决方案榜首,现在很多大厂的机器学习方案依旧会首选这个模型。XGBoost在并行计算效率、缺失值处理、控制过拟合、预测泛化能力上都变现非常优秀。

LightGBM

LightGBM是微软开发的boosting集成模型,和XGBoost一样是对GBDT的优化和高效实现,原理有一些相似之处,但和XGBoost相比,拥有更快的训练效率、更低的低内存使用、更高的准确率、支持并行化学习、可处理大规模数据、支持直接使用category特征等优点。

MLP+Embedding

神经网络算法在数据科学模型中有时候会有让人眼前一亮的表现。神经网络模型的主要特点是不能有缺失值,缺失值在入模之前需要提前填充。MLP+Embedding是最常用的解决数据科学竞赛问题的框架。MLP(Multi-Layer Perceptron),即多层感知器,是一种趋向结构的人工神经网络,映射一组输入向量到一组输出向量。Embedding是处理离散型变量的重要模块,它可以避免因为使用one-hot导致稀疏矩阵过于庞大,浪费资源。

Tabnet

由于对于某些任务,NN模型(Neural Network Model)的表现只能算差强人意,而我们又需要有NN模型参与最后的模型ensemble,机智的研究者们为此设计出了类似树模型的NN模型——TabNet,它在保留DNN的end-to-end和representation learning特点的基础上,还拥有了树模型的可解释性和稀疏特征选择的优点,这使得它在具备DNN优点的同时,在表格数据任务上也可以和目前主流的树模型相媲美。

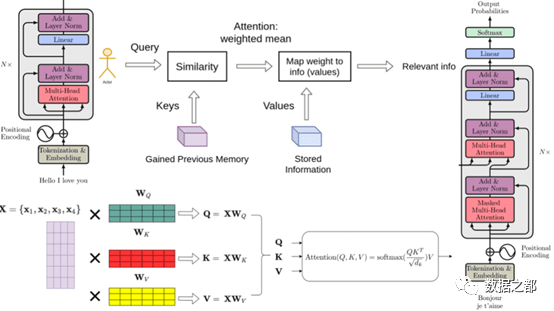

Transformer

Transformer模型在处理时序数据上具有不错的效果。Transformer出自于Google于2017年发表的论文《Attention is all you need》,最开始是用于机器翻译,并且取得了非常好的效果。但是自提出以来,Transformer不仅仅在NLP领域大放异彩,并且在CV、RS等领域也取得了非常不错的表现。尤其是2020年,绝对称得上是Transformer的元年,比如在CV领域,基于Transformer的模型横扫各大榜单,完爆基于CNN的模型。然而他在处理时序问题的时候,通过encoder和decoder,也会有比较惊人的表现。

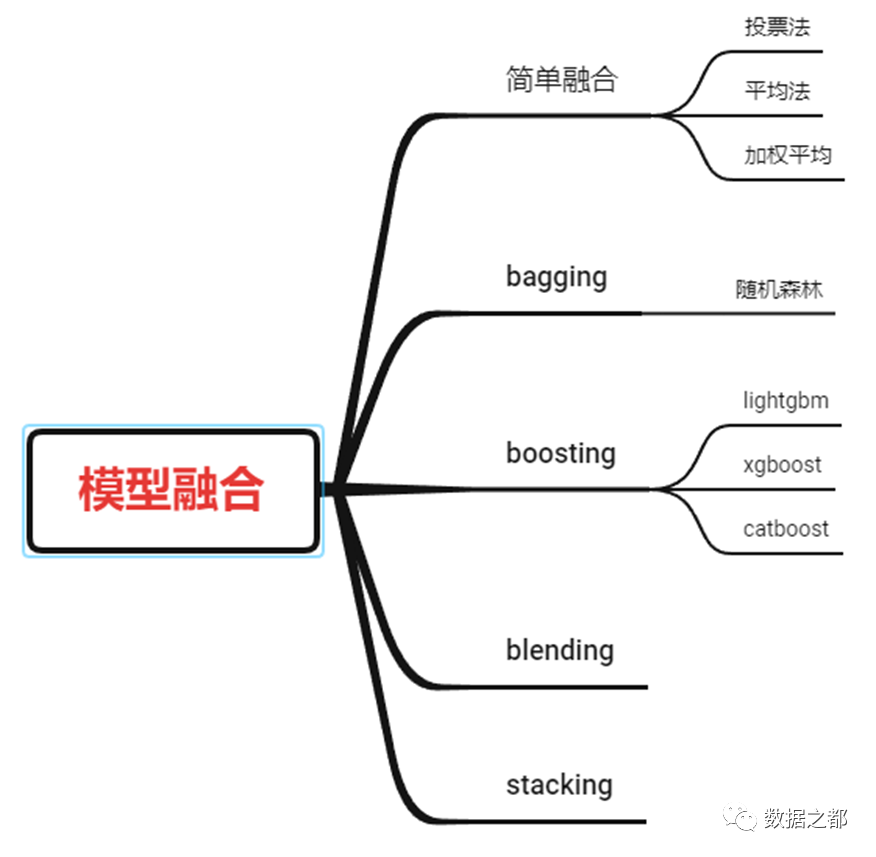

3 模型融合

Kaggle前排方案肯定不是单一模型,都会通过多个模型去做融合。模型融合虽然在绝对值上可能只提高了千分之一的水平,但是却可以极大的提高比赛的名次。下图列出了几种常用的模型融合方法,可以供大家参考。