不会真的有“大聪明”直接用AI写论文吧?

咱抛开学术道德不谈,就从实际操作的角度来说,你确定AI写出来的论文能逃过导师的法眼?自然科学想都不要想,人文社科风险也很大。

如果真不想要学位证,其实大可不必这么麻烦。至于草案提出的——“人工智能代写”问题,当前甚至未来相当长的阶段我其实完全不担心。

你可以把它看做一把高悬头顶的达摩克利斯之剑,但大多数时候只要你不头脑一热全盘AI,大概率也不会落到自己头上。

原因:

1、想要准确地识别AI撰写的内容非常困难,“错杀”的概率很高。

2、容易识别出来的部分,其实都跟AI关系不大,基本都属于传统学术不端范畴。

AI写论文,只是看上去很美好

AI这阵风吹来,仿佛一下子颠覆了好多行业。

但真相是,大多数人其实没办法从AI这里获得帮助。

就比如用AI写论文,大部分小伙伴都是嘴上说说要用AI代写,但实际还是自己吭哧吭哧写。因为真的实际操作下来一定会发现,AI写出来的论文,导师看了怕不是直接丢垃圾桶吧。

毕竟,目前的AI,想要用它来写论文,只是“看起来有用”,但实际没啥用。

AI写出来的东西最典型的特点就是言之无物。

对于一篇科研论文,判断它是不是合格的论文的核心要素只有一点——有实验、数据所支撑的研究内容,并据此得出结论。

至于你原创了什么,你导师最清楚不过。他就算只为自己的前途考虑,也不会允许你凭空捏造数据和实验结果的。

而论文里最不值钱的就是那些啰里啰嗦的废话,可AI恰好只能生成那些言之无物的废话。毕竟原理摆在那,AI只是在预测“下一个最大概率的词是什么”,并不能为你凭空写出任何“原创”的内容。

这些废话其实你不用AI,自己拿三五篇文献凑吧凑吧也很容易凑出来。

如果你非要用AI,只不过加速了这个“凑”的过程。

所以,与其恐惧AI代写,不如还是多关注数据造假、杜撰结果这些传统的“学术不端”行为。

而且,实际操作中识别AI生成内容其实非常容易“错杀”,这就决定了这条草案将很难被很好地执行。

对AI生成内容的识别“不准”

我随手做了个实验,看看我用AI刚刚编的一篇小短文:

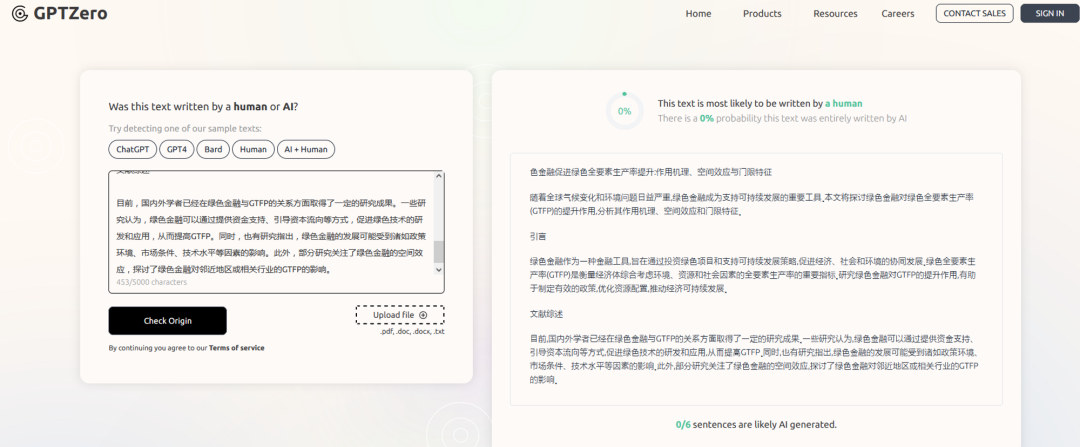

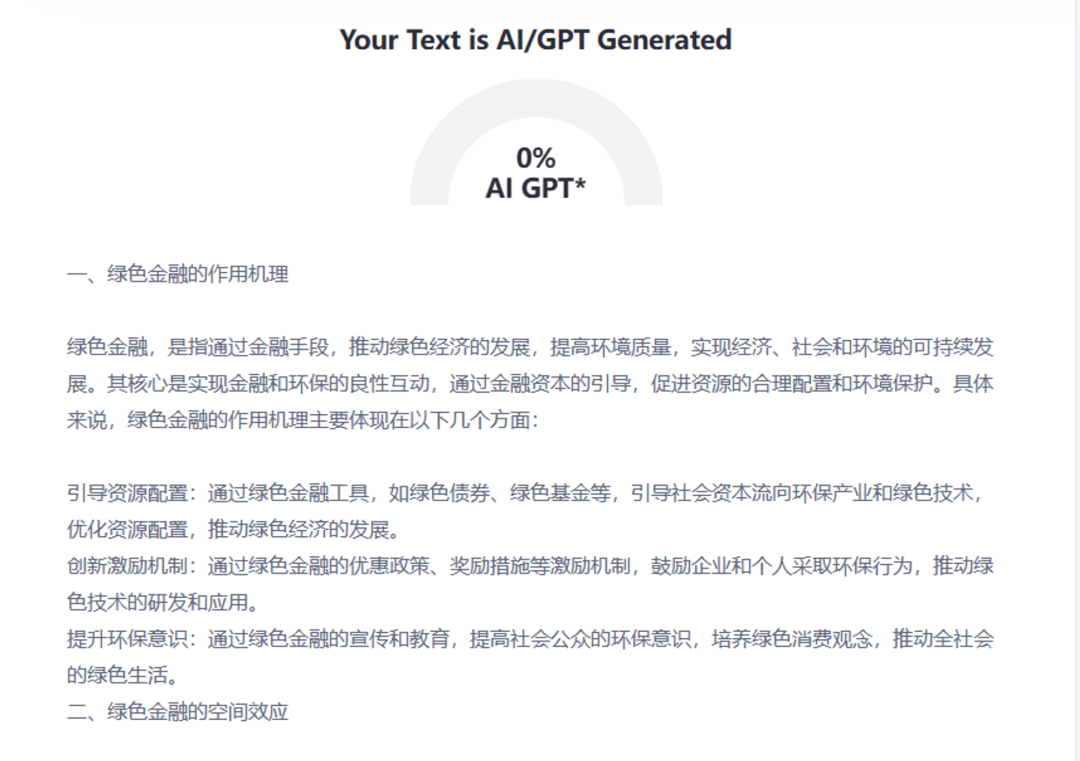

我试用了两个非常流行的AI内容检测器:

GPTZero的结果:

这个是ZeroGPT的检测结果:

结果只能说差强人意。我又做过几个测试,反而我真实写的某一篇乱七八糟的文章,被识别为AI写作的概率却非常高。只能说是一种迷之概率了。

其实,目前AI内容检测还有很长的路要走,而且有很多绕不开的难题。比如:

1、不同AI检测器,使用的算法和方法不同,检测结果也不一样。

2、随着时间的变化(AI检测器训练数据的变化),人工写作的内容也可能被识别为AI生成。

其实这些问题都是由AI检测器的原理决定的。AI检测器是以大量文本训练和推测规则为监测基础。说得直白一些,AI根据“经验”和一些“规则”来决定被检测内容是否是AI生成。这种规则是我们可以学习甚至规避的。比如最常用的一条AI检测规则就是”变化性“,即人类写作往往具有“变化性,文本中句子长短不一交替变化,而AI往往并不具有这一属性。

但是,人类其实也可以凭借“经验”来写作,同时AI也可以模仿人类的写作“风格”。

其实现在你就可以找到很多“绕过AI检测“的提示词,比如写出某个提示词后,生成的内容在专门的AI检测工具检测中完全识别不出来。

“检测错误”是一个不能规避的问题。当一篇文章你没法确保100%(甚至都不用这么准确)准确的检测出是否AI写作的时候,这一条法规基本就形同虚设。

话说回来,实际操作中,真正能用到AI为论文”提速“的其实有两个部分,这也是立法者和论文审查者需要注意的(绝不是教你怎么用AI偷懒哈)。

片段补全/扩写

其实很多人写论文的时候,最苦恼的是自己字数不够。

于是就有小伙伴动了脑筋,比如把一句简明扼要的话,让AI给你扩写一下。

比如这样——

(这句话是我根据随便一篇论文自己编的)

AI扩写出来这句话,其实相当于详细解释了一下我给的那句话。

但是,仔细阅读下来,你会发现一个大Bug!

——AI直接把你的研究方法和路线说出来了(构建CTD和PPI网络,分析关键成分和靶点以及成分和其他分子的相互作用),但你确定你是按照AI说的这样做的吗?

这又回到了我们最开始说的那个无解难点,AI毕竟没办法提供真实的,符合你工作的实验数据和方法。

尽管AI提供了“最有可能”的方法表述,但它不一定就是你的实验方法!

对于这种程度的AI代写,识别方法不要太简单,只要你论文提到的内容并没有实际去做,没有实验数据,那直接挑出来准没错。

至于用AI写出来的那些言之无物的废话,其实和你自己写的没啥区别。因为你很可能参考了若干篇同领域的文章,凑出了那一段废话。

中译英&英译中

为了降重,大家早就各显神通了。

比如流行最广泛的一个招数,先把中文语句翻译成英文,然后再把英文翻译成中文,重复率一下子就降下来了。

这个招数在没有AI之前大家已经玩的贼6了,有了AI只不过更加如虎添翼。

尤其是用庞大的英文语料训练出来的ChatGPT,有些时候写出来的东西堪比native speaker。

不过这个办法很多小火把其实以前就在用,现在只不过更好用了一点而已。

例子我都懒得举了,大家操作起来不要太娴熟。当然,为了保证你的文章可读性,一般来讲这么颠倒一遍之后,还需要自己改一改的。

我之前听过好几位老师用AI去润色文章,效果还不错,但总感觉和专家润色差了那么一点味道。仔细分析原因,AI虽然给了你非常地道的表述,但是否符合你的论文调性,是否契合你的研究,AI并没有办法做到“专家水平”。

现在看来,AI取代传统的翻译已经近在眼前,但距离真正的“专家”还有一段路要走。

其实回头来看,虽然AI这阵风刮得越来越猛,似乎哪个领域都能参合一脚,但实际操作中,并没有这么美好。

想要写出论文,甚至发表出来,大多数工作还是需要踏踏实实地去完成。AI只能在这个过程中小小的辅助一把,甚至AI做过的工作,你还需要亲自再检查和修改一遍。

毕竟如果你辛辛苦苦做了一篇工作,最后因为“貌似”AI写作被“误伤”,岂不是很可惜。“人”的作用,在科研创新中还会长期处于核心地位。

AI虽好,不过只有会用的人才会从中得到益处。不必过于担心由于自己用AI帮了点小忙而被撤销学位证,毕竟这事想要扯皮太容易。

当然,不要“all in AI”。这样做一篇论文,不论你的导师还是评审专家,大概会一眼发现吧。

这个时候,尤为凸显人工审稿的体贴和深入。以意得辑的科学深度编辑服务为例,我们将分别指派一位拥有高影响期刊同行评审经验的审稿人、一位拥有20余年经验的学科编辑、及一位年均协助百位作者发表的执行编辑通力合作,用高分期刊的接受标准来要求你的稿件。

由这三人组成的专家团队并不单局限于对文章语言咬文嚼字,还会从内容和投稿规范两个层面做细致检查。最终将合力写就一份科学深度评估报告,简单明了地告诉你要想发顶刊还要作出哪些努力。

学科专业深度、文章逻辑条理、心仪期刊标准分析……这些AI目前还远无法满足的标准,我们的科学深度编辑服务都将一一达成。学术道路荆棘遍地,小e一路与您随行。